Пиастры – Составление семантического ядра

Предыдущая часть мануала

Сегодня будем говорить про самое ответственное после выбора ниши. Будем собирать запросы, по которым наш сайт должен занять лидирующие позиции и собирать трафик с поисковых систем. Задача непростая, про нее написано огромное количество материалов в сети. Теме не менее нам надо подробно разобраться, как оптимально делать этот пласт работы.

Сегодня будем говорить про самое ответственное после выбора ниши. Будем собирать запросы, по которым наш сайт должен занять лидирующие позиции и собирать трафик с поисковых систем. Задача непростая, про нее написано огромное количество материалов в сети. Теме не менее нам надо подробно разобраться, как оптимально делать этот пласт работы.

Стандартные методы подбора запросов

Как я уже сказал, в сети есть огромное количество материалов по теме. Я не хочу останавливаться подробно на тривиальных методах, но перечислить их все же надо.

Какие есть методы:

- Яндекс Директ – классика жанра. проводим мозговой штурм, засовываем запросы в сервис с целью расширения списка запросов, чистим от мусора, смотрим правый столбец, засовываем новые запросы в сервис снова. И так до бесконечности. Очень трудозатратный метод.

- База Пастухова, хороший инструмент, стоит своих денег, в данный момент русскоязычная база запросов содержит более миллиарда слов.

- Поисковые подсказки, интересный метод, который руками практически нереализуем. Но есть сервисы: http://keywordshitter.com/, http://keywordtool.io/ru(подсказки из гугла, ютуба, бинга, апп сторе) и т.п.

- Отдельно надо выделить инструмент КейКоллектор, программа, которая умеет очень многое и облегчает жизнь огромному количеству сеошников.

Зачем изобретать велосипед?

Я этот вопрос задаю часто, особенно часто, когда вспоминаю фильм Пираты кремниевой долины. Если кто не смотрел, то вкратце суть такая. Богатым, успешным, знаменитым становится не тот, кто придумывает что-то новое, а тот, кто вовремя подсуетился и смог это выгодно масштабировать/продать. Из фильма вы узнаете, что Билл Гейтс, например, продал свою первую операционку, когда не было ни одной строчки кода, а по факту Dos он купил у неизвестного программиста за 50к бакинских рублей.

Еще интересный момент. То, к чему мы так привыкли – визуальные элементы интерфейсов, кнопки, мышки и т.п. Все это придумала компания Xerox, но не смогла продать IBM. За то Apple успешно своровала все это у Xerox, а затем МикроМягкие сперли все это у Apple и продали все красиво под видом Windows.

Внимание вопрос: где сейчас Ксерокс, кто-нибудь помнит того программиста, который написал операционную систему Dos? Так что не стоит думать, что вы самые умные и быстрые, не надо делать работу, которую уже за вас кто-то проделал. Есть варианты скопировать, о них и поговорим, т.к. лень у нас в крови.

Открытые источники статистики

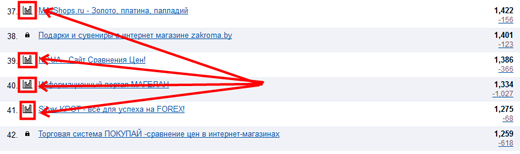

Вроде бы очевидные вещи, но многие до конца не понимают, что делать с богатством, которое нам предоставляет сервис топ.майл.ру. Объясняю на пальцах. Идем в рейтинг, например, в раздел Рейтинг > Деловой мир > Электронная коммерция, ищем интересные сайты с открытой статистикой:

На самом деле искать сайты надо на этапе подбора потенциальных ниш.

Я для примера выбрал тему с высокими бидами, стратегии Форекс, нашел сайт strategy4you.ru, с трафиком более 1000 человек в день и открытой статистикой.

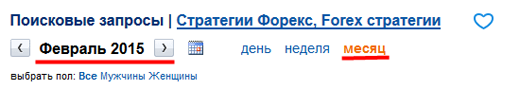

Идем в статистику, выбираем интервал отображения статистики Месяц, берем предыдущий полный месяц:

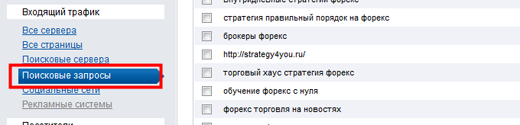

Далее в левом боковом меню выбираем раздел Входящий трафик, подраздел Поисковые фразы:

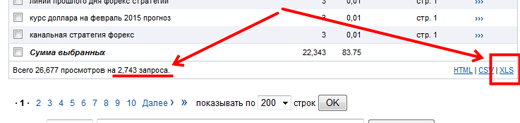

Опускаемся вниз страницы, видим, что мы нарвались на кладезь информации, т.к. список содержит более 2 700 фраз, по которым пришли реальные посетители на сайт в феврале. Нажимаем на ссылку экспортировать в Excel.

В открытом файле видим небольшую проблемку: экспортировался не весь список, а только те фразы, которые показываются на странице. Но для нас это не беда, пройдемся по страницам и потом объединим файлы.

Итоговый файл надо почистить от запросов, которые вы считаете левыми. Думаю, с этим вы сами справитесь.

Что делать со списком дальше? Для полноценного ядра нам необходимо две вещи: суп и хлеб. Шучу! Нам необходимы 2 вещи:

- Частота запросов,

- Группировка запросов по страницам.

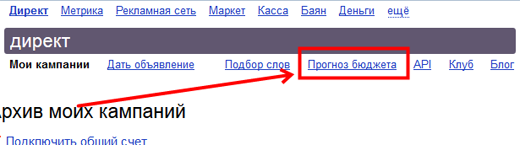

Сначала будем разбираться с частотой. Идем в Я.Директ, авторизуемся, переходим в раздел прогноз бюджета:

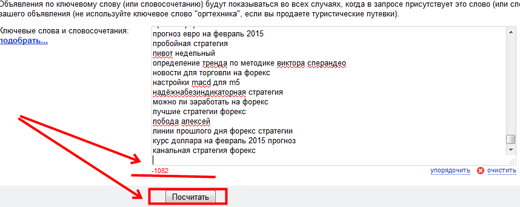

Вставляем наш список, система будет ругаться, что много данных, но не стоит на это обращать внимание, работать от этого она хуже не станет. Кликаем на кнопку Посчитать.

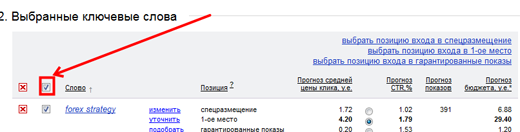

Следующий шаг, поставить галку в указанном на картинке месте:

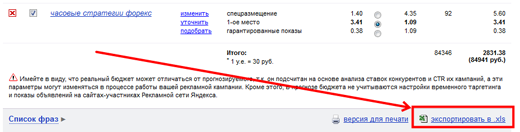

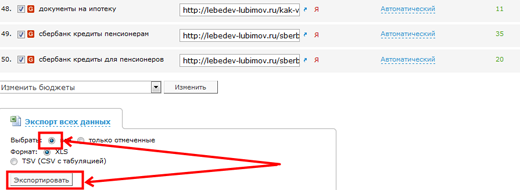

Спускаемся вниз страницы, экспортируем данные в Excel:

Частоты у нас есть, осталось сгруппировать. Кстати, хороший вопрос: а что делать с запросами с нулевой частотой? Я бы их не стал удалять, а отложил. Позже они нам могут очень понадобиться!

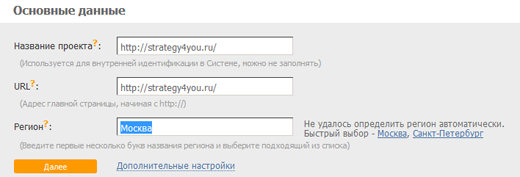

Идем в Сеопульт, авторизуемся, создаем новый проект, прописываем адрес нашего сайта:

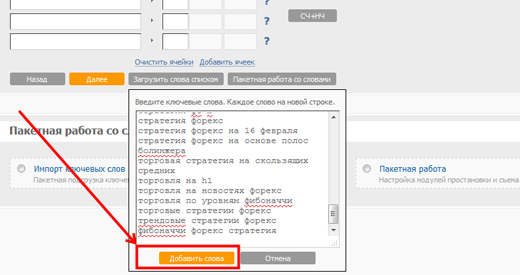

Добавляем запросы списком:

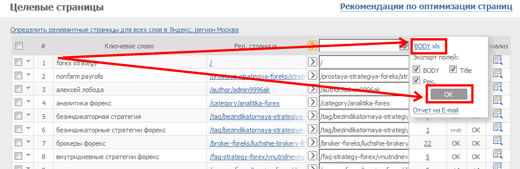

Нажимаем Далее, ждем когда система все обсчитает. Экспортируем данные в Excel:

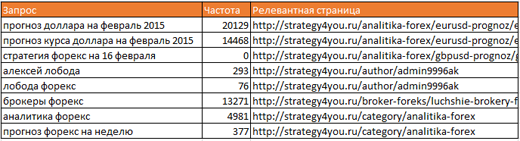

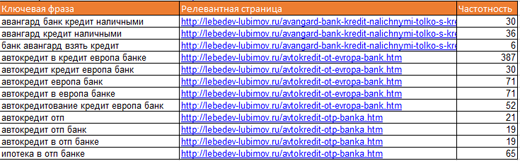

Объединяем все в одну таблицу: запросы, частоты, релевантные страницы:

Получается весьма неплохо, а главное, быстро! Дальше вопросов возникать не должно. С ядром можно работать уже руками и головой, больше автоматизировать здесь нечего.

Анализ оптимизации конкурентов

Вторым неочевидным, но простым методом является анализ оптимизации ключевых тегов страниц конкурентов. То есть задумка проста:

- Получаем список страниц сайта конкурента.

- Отбираем те, которые являются контентными, то есть содержат информационные статьи.

- Анализируем титлы, то есть выясняем под какие запросы страница оптимизирована.

- Запросы расширяем, пробиваем частоты.

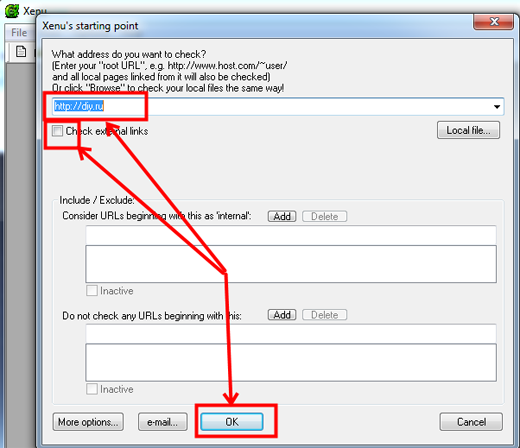

Итак, нам понадобится программа, которая называется Xenu (найдете сами, не проблема), она умеет сканировать сайты, почти как бот поисковой системы.

Запускаем Xenu, идем в меню File, New, вводим адрес сайта (конкурента, которого мы нашли при выборе ниши), снимаем галочку Check external links, если такая стоит, нажимает Ok.

Если конкурент большой, то ждать придется долго, поэтому я сканирую данные заранее, в процессе анализа ниш. Бывает, что Xenu не выключается неделями на нескольких компьютерах.

После сканирования сортируем данные по Type, в результате получится что-то типа вот такого:

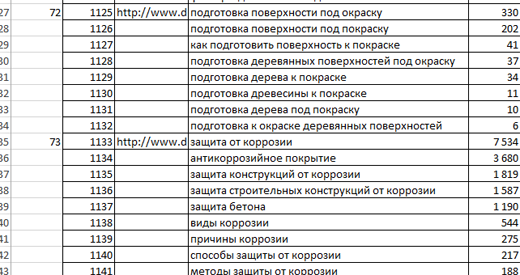

Следующий наш шаг, понять из титлов, какие главные запросы используются конкурентом в статье. Обычно это 1-3 запроса, которые мы можем расширить элементарно, забивая их в директ и очищая от мусора. Работа рутинная, практически не требующая интеллектуального труда. Получаем таблицу, на основе которой будем делать задания копирайтерам:

Базы данных агрегаторов

Скоро исполнится 10 лет, как в рунете появились ссылочные биржи с нормальным функционалом для людей. За все время работы ими накоплена серьезная статистика как по поисковым запросам, так и по видимости определенных сайтов по ним.

Этот метод мне очень симпатичен, хотя его точность хуже по сравнению с предыдущим. Но за то здесь практически ничего не надо делать руками.

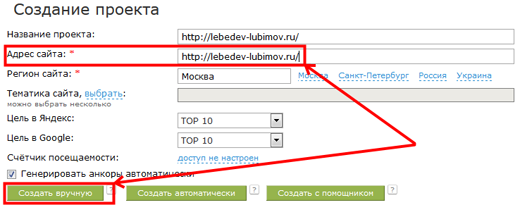

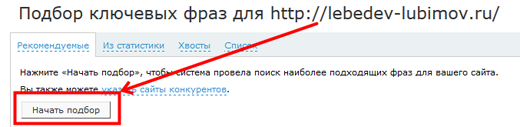

Итак, регистрируемся в Сапе.Визард, если еще этого не сделали. Создаем новый проект, вводим адрес сайта конкурента, которого будем анализировать. Я возьму денежную тему, то есть кредиты и сайт буду смотреть http://lebedev-lubimov.ru/. Сайт мне нравится своей основательностью, молодцы создатели, зарабатывают кругом где только можно!

Следующим шагом нам надо заставить систему порыться у себя в базе и найти запросы, ко которым сайт имеет хоть какую-то видимость:

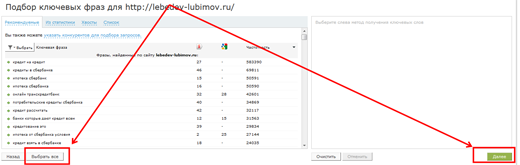

Выбираем все и нажимаем заветную кнопку Далее, которая запускает волшебный механизм обработки ядра запросов.

Система может достаточно долго обсчитывать данные, подождем, оно того стоит. В нашем примере мы получили ядро порядка 1400 запросов. Экспортируем его в Excel.

Получилась золотая таблица: запросы, релевантные страницы, геозависимость, частоты, бюджет на ссылки. На данный момент нам нужно отсортировать список по релевантным страницам, скрыть пока не нужные поля. Все: ядро готово!

Наверное, можно было бы на этом остановиться, но все же стоит еще немного рассказать фишек.

Сбор ядра на автопилоте

Данная часть посвящена тем, кто умеет программировать, остальным информация будет бесполезна.

Честно говоря, я не знаю, есть ли API у Визард.Сапе, наверное, есть хотя бы для избранных пользователей. Но нам не обязательно. Процессы, которые мы разбирали в данном опусе вполне поддаются автоматизации.

Этапы сборы семантики:

- подбор широкого ядра запросов,

- подбор релевантных страниц,

- проверка актуальных частот.

Подробнее по каждому этапу:

- Сбор семантики для конкретного сайта: используем API Мегаиндекса, метод siteAnalyze. На выходе получите что-то типа: test siteAnalyze.

- Далее используем Я.ХМЛ для подбора релевантных страниц. Соответственно список сортируем, чтобы добиться группировки по урлам. На выходе получаем разбитое семантическое ядро по страницам.

- Далее надо пробить частоты по собранному ядру. Для этого можно опять использовать API Мегаиндекса, методы: раз, два, три

Итого: готовое ядро в один клик за одну минуту 😉

На этом сегодня все! Делаем ядра для сайтов в рамках домашнего задания!

<< Предыдущая часть мануала Следующая часть мануала >>>

Пиастры - Создаем сайт Пиастры - Создаем сайт |  Пиастры - Выбор и оценка ниши Пиастры - Выбор и оценка ниши |

Пиастры - Введение Пиастры - Введение |  Пиастры за контекст на бутылку рома - финал марафона Пиастры за контекст на бутылку рома - финал марафона |

Увеличиваем траф в 8 раз, поднимаем доход в 5 раз!

Увеличиваем траф в 8 раз, поднимаем доход в 5 раз! Улучшение поведенческих факторов сайта

Улучшение поведенческих факторов сайта Фильтры Гугла или Google Penguin 3.0 в действии

Фильтры Гугла или Google Penguin 3.0 в действии

Hey very interesting blog!

Hmm is anyone else experiencing problems with the pictures on this blog loading?

I’m trying to find out if its a problem on my end or if

it’s the blog. Any feed-back would be greatly appreciated.

Superb site you have here but I was wondering if you knew of any discussion boards that cover

the same topics discussed in this article? I’d really like to be a part of group where I can get comments from other

experienced people that share the same interest.

If you have any recommendations, please let me know. Many

thanks!

It’s amazing for me to have a website, which is beneficial

in favor of my experience. thanks admin

Tonton video sex ngentot online HD gratis di situs saluran terpopuler di dunia dan Temukan film-film seks

hardcore bintang porno

sex

These are genuinely impressive ideas in regarding blogging.

You have touched some nice points here. Any way keep up wrinting.

Hello, all is going perfectly here and ofcourse

every one is sharing facts, that’s actually excellent, keep up writing.

I love it when individuals come together and share thoughts.

Great blog, stick with it!

I’d like to find out more? I’d like to find out some additional information.

For the reason that the admin of this site is working,

no question very rapidly it will be renowned, due to

its feature contents.camisetas de futbol

Keep this going please, great job!

Good article! We are linking to this particularly great post on our website.

Keep up the good writing.

That is a good tip especially to those new to the blogosphere.

Short but very precise info… Thank you for sharing this

one. A must read post!

We are a group of volunteers and opening a new scheme in our community.

Your website provided us with valuable information to work on. You’ve

done an impressive job and our entire community will

be thankful to you.

An intriguing discussion is definitely worth comment. I do believe that you need to write more about this issue, it may

not be a taboo matter but typically people do not discuss such issues.

To the next! Kind regards!!

Also visit my blog :: LOTTOUP

What’s up mates, how is all, and what you want to say concerning this article,

in my view its really remarkable in support of me.

Everyone loves it whenever people get together and share views.

Great blog, stick with it!

I do not even understand how I ended up here, however I assumed this publish used

to be good. I don’t know who you are however definitely you are going

to a well-known blogger in case you aren’t already.

Cheers!

Howdy I am so excited I found your web site,

I really found you by accident, while I was browsing

on Bing for something else, Nonetheless I am here now and would just like to say thank you for a fantastic post and a all round thrilling blog

(I also love the theme/design), I don’t have time to read it all at the

minute but I have book-marked it and also included your RSS feeds, so

when I have time I will be back to read more, Please do keep

up the superb work.

Howdy! I could have sworn I’ve been to this web site before but after looking at some of the posts I

realized it’s new to me. Nonetheless, I’m definitely happy I

stumbled upon it and I’ll be book-marking it and checking back often!

I constantly spent my half an hour to read this website’s posts every day along with a cup of

coffee.

For most recent news you have to visit the web and on internet

I found this site as a best web page for most up-to-date

updates.

You are so awesome! I do not suppose I have read through something like that before.

So great to discover another person with a few unique thoughts on this subject.

Seriously.. thank you for starting this up. This web site is one thing that is needed on the web,

someone with a bit of originality!

The Brad Hendricks Law Firm has the TRADITION of working

hard to resolve the legal problems faced by individuals and businesses throughout the state of Arkansas.

We also have the REPUTATION of devoting the time and

attention your case deserves in order to win your

case. We draw upon over 275 years of combined experience and RESULTS-driven success

to represent you in a range of legal needs. It is our service that has made The Brad Hendricks Law Firm one of the most successful law firms in the state for over twenty-five years.

I do not even understand how I stopped up right here, however I thought this publish used to be good.

I do not understand who you might be but certainly you’re going to a well-known blogger for those who are not already.

Cheers!

It’s truly very complex in this busy life to listen news on TV, so I just use the web for that reason, and obtain the

most recent news.

Thanks for a marvelous posting! I certainly enjoyed reading

it, you might be a great author. I will always bookmark your blog

and will eventually come back down the road. I want to encourage one to

continue your great posts, have a nice evening!

Magnificent beat ! I would like to apprentice at the same

time as you amend your website, how could i subscribe for a weblog website?

The account helped me a acceptable deal. I have

been a little bit familiar of this your broadcast provided vibrant clear idea

my web page :: LOTTOUP

Hey are using WordPress for your site platform?

I’m new to the blog world but I’m trying to get started and create my own. Do you

require any coding expertise to make your own blog?

Any help would be greatly appreciated!

Feel free tⲟ surf to mу рage: hotels in Taormina Sicily

Thanks for finally talking about > Пиастры – Составление семантического ядра | < Loved it!

Incredible points. Solid arguments. Keep up the good work.

I enjoy what you guys are usually up too.

This sort of clever work and coverage! Keep up the fantastic works guys I’ve incorporated

you guys to my personal blogroll.

Hey there! I just wanted to ask if you ever have any trouble with hackers?

My last blog (wordpress) was hacked and I ended up

losing several weeks of hard work due to no backup. Do you have any

solutions to stop hackers?

Its like you read my mind! You appear to know a lot about this,

like you wrote the book in it or something.

I think that you could do with some pics to drive the

message home a bit, but other than that, this is magnificent blog.

A fantastic read. I will certainly be back.

If some one wants to be updated with latest

technologies therefore he must be visit this web site and be up to date all the time.

Stop by my web blog web01.kokoo.kr

Admiring the commitment you put into your blog

and in depth information you provide. It’s awesome to come across a

blog every once in a while that isn’t the same out of date rehashed material.

Great read! I’ve saved your site and I’m adding your RSS feeds to

my Google account.

Pretty! This was an extremely wonderful post. Thanks for supplying this

information.

Hi my loved one! I wish to say that this post is awesome, nice written and

come with almost all important infos. I would like to look more

posts like this .

Greetings! Very helpful advice in this particular article!

It’s the little changes that will make the most significant changes.

Many thanks for sharing!

Good day! I could have sworn I’ve visited this site before but after looking at a few of the posts I

realized it’s new to me. Anyways, I’m definitely delighted I stumbled upon it and I’ll be book-marking it and checking back frequently!

WOW just what I was looking for. Came here by searching for Cost of addiction

This design is wicked! You most certainly know how to keep

a reader amused. Between your wit and your videos, I was almost moved to start my

own blog (well, almost…HaHa!) Excellent job. I really enjoyed

what you had to say, and more than that, how you

presented it. Too cool!

Way cool! Some very valid points! I appreciate you penning

this write-up and also the rest of the website is also very

good.

Whats up are using WordPress for your blog platform?

I’m new to the blog world but I’m trying to get started and create my own. Do you require any coding expertise to

make your own blog? Any help would be really appreciated!

This post is worth everyone’s attention. When can I find

out more?

Its like you read my mind! You seem to grasp so much approximately this, such as you wrote the ebook

in it or something. I feel that you could do with a few

percent to drive the message home a little bit, however instead of that, this is excellent

blog. A fantastic read. I will definitely be back.

You have made some good points there. I looked on the web for more info about the issue and

found most individuals will go along with your views on this web

site.

After going over a number of the blog articles

on your web site, I really like your technique of writing a blog.

I book-marked it to my bookmark website list and will be checking back soon. Take a look

at my website as well and let me know how you feel.

This blog was… how do I say it? Relevant!! Finally I’ve found something which helped me.

Thanks a lot!

I constantly spent my half an hour to read this web site’s posts everyday along

with a mug of coffee.

I’m really enjoying the design and layout of your blog. It’s

a very easy on the eyes which makes it much more pleasant

for me to come here and visit more often. Did you hire out a developer to create your theme?

Excellent work!

Please let me know if you’re looking for a author for your site.

You have some really good posts and I feel I would be a good asset.

If you ever want to take some of the load off, I’d really like

to write some articles for your blog in exchange for a link back to mine.

Please shoot me an email if interested. Kudos!

This paragraph is actually a pleasant one it helps new the web viewers, who are wishing for blogging.

Magnificent goods from you, man. I have understand your stuff previous to and you’re just extremely excellent.

I actually like what you’ve acquired here, certainly like what you are stating and the way

in which you say it. You make it enjoyable and you still care for to

keep it wise. I cant wait to read much more from you.

This is really a great web site.

There’s certainly a lot to learn about this topic.

I really like all of the points you’ve made.

It is the best time to make some plans for the future and it is time to

be happy. I’ve read this post and if I could I wish to suggest you few interesting things or advice.

Perhaps you can write next articles referring to

this article. I desire to read more things about it!

Hi, i feel that i noticed you visited my blog thus i came to go back the choose?.I am

trying to to find things to improve my site!I assume

its ok to use some of your ideas!!

Thank you for the auspicious writeup. It in fact was a amusement account it.

Look advanced to more added agreeable from you!

However, how can we communicate?

If some one desires expert view on the topic of blogging

and site-building after that i recommend him/her to pay a visit this website, Keep up the good work.

La detección temprana y el tratamiento adecuado del cáncer de mama

tienen la posibilidad de socorrer vidas y prosperar la calidad

de vida de las mujeres perjudicadas..

If you are going for most excellent contents like I do, only pay a

visit this web site daily for the reason that it presents quality contents, thanks

You’re so awesome! I do not believe I’ve read anything like that before.

So wonderful to find someone with some unique thoughts on this

issue. Seriously.. thanks for starting this up. This site is something that is needed on the

web, someone with a little originality!

Excellent blog here! Also your website loads up fast! What host are yyou using?

Can I get your affiliate link to yourr host? I wish myy site loaded up as fast as yours lol

webpage

Heya! I’m at work browsing your blog from my new iphone!

Just wanted to say I love reading through your blog and look forward

to all your posts! Keep up the excellent work!

Wow! This blog looks exactly like my old one! It’s on a completely different subject but it has pretty

much the same page layout and design. Wonderful choice of colors!

My brother suggested I might like this blog. He was totally right.

This post truly made my day. You can not believe just how much

time I had spent for this information! Thanks!

This piece of writing will help the internet users for building up

new weblog or even a blog from start to end.

Hello there, just became alert to your blog through Google,

and found that it is truly informative. I am going to watch out for brussels.

I will appreciate if you continue this in future. Many people will be benefited

from your writing. Cheers!

Appreciation to my father who told me regarding this blog, this website

is genuinely amazing.

It is the best time to make some plans for the future and it is time to be happy.

I’ve read this post and if I could I want to suggest you

few interesting things or advice. Perhaps you could write next

articles referring to this article. I desire to read more things about it!

I was able to find good advice from your blog

articles.

great issues altogether, you simply won a new reader.

What may you recommend about your submit that you made a few days in the past?

Any positive?

I blog frequently and I truly thank you for your content.

This great article has truly peaked my interest. I am going to take a note

of your blog and keep checking for new details about once per week.

I opted in for your Feed too.

Hi mates, its enormous paragraph about teachingand entirely defined,

keep it up all the time.

Excellent beat ! I would like to apprentice whilst you amend your website, how

can i subscribe for a weblog site? The account aided me a acceptable deal.

I were tiny bit acquainted of this your broadcast provided

vibrant clear concept

excellent submit, very informative. I’m wondering why the opposite specialists

of this sector don’t realize this. You should proceed your writing.

I’m sure, you have a great readers’ base already!

I really like your blog.. very nice colors & theme. Did you

design this website yourself or did you hire someone to do it for you?

Plz answer back as I’m looking to construct my own blog and would like to know where u got this from.

appreciate it

Hi there, I enjoy reading through your article.

I wanted to write a little comment to support you.

What’s up mates, its fantastic article regarding tutoringand entirely

explained, keep it up all the time.

Excellent article! We will be linking to this particularly great content on our site.

Keep up the great writing.

I visited various sites however the audio feature for audio songs current at this web

page is genuinely excellent.

Hi, just wanted to mention, I liked this blog post. It was helpful.

Keep on posting!

What’s up i am kavin, its my first time to commenting anywhere, when i read this paragraph i thought i

could also make comment due to this good piece of writing.

Heya i’m for the first time here. I came across this board and I to find It truly helpful & it helped me out

a lot. I hope to provide one thing again and help others such

as you helped me.

Hi! I could have sworn I’ve been to this site before but

after checking through some of the post I realized it’s

new to me. Anyways, I’m definitely happy I found

it and I’ll be book-marking and checking back often!

Spot on with this write-up, I seriously believe this web site needs

a lot more attention. I’ll probably be back again to see more, thanks for the information!

Hi there, You’ve done an incredible job.

I will certainly digg it and personally suggest to my

friends. I am sure they’ll be benefited from this site.

Hi, i think that i saw you visited my site so i came to “return the favor”.I’m trying to find things to

improve my web site!I suppose its ok to use a few of your ideas!!

Hey are using WordPress for your blog platform?

I’m new to the blog world but I’m trying to get started

and create my own. Do you require any coding expertise to make

your own blog? Any help would be greatly appreciated!

Hi there to every one, it’s in fact a nice for me to go to see this web page, it consists of valuable Information.

Terrific post but I was wondering if you could

write a litte more on this topic? I’d be very thankful if you could elaborate a

little bit further. Many thanks!

ทางเราจำหน่าย relx

Infinity , relx Bubble Mon , Infy Pod ต้องขอบอกได้เลยว่า kschill.com เป็นตัวแทนหลักอย่างเป็นทางการในไทย ที่ใหญ่ที่สุด และเป็นเจ้าเดียวกับ RELX THAILAND สินค้าทุกแบรนด์

ทุกรุ่น เราได้ทำการคัดสรร บุหรี่ไฟฟ้า

ที่เป็นหนึ่งในนวัตกรรม ช่วยเลิกบุหรี่ ที่มีประสิทธิดีเยี่ยม และช่วยได้จริง มาให้ลูกค้าได้เลือกใช้ โดยสินค้าทุกชิ้นของเรา สั่งตรงจากโรงงาน

Excellent web site you have here.. It’s hard to find quality writing like yours these days.

I seriously appreciate people like you! Take care!!

MEGA-FERMA

Hi there, everything is going sound here and ofcourse every one is sharing data, that’s truly fine, keep up writing.

Hey there! This is kind of off topic but I need some guidance from an established blog.

Is it very difficult to set up your own blog? I’m not very techincal but I can figure things out pretty fast.

I’m thinking about making my own but I’m not sure where to

begin. Do you have any tips or suggestions? Thanks

Thank you for sharing your thoughts. I truly appreciate your efforts and I will

be waiting for your further post thanks once again.

Hello! Someone in my Facebook group shared this site with us so I came to take a look.

I’m definitely loving the information. I’m book-marking and will be

tweeting this to my followers! Fantastic blog

and outstanding design.

Hello there! This article could not be written any better!

Reading through this post reminds me of my previous roommate!

He continually kept talking about this. I’ll send this post to him.

Fairly certain he’ll have a great read. Many thanks for sharing!

What’s up to every one, the contents existing at this site

are actually remarkable for people experience, well,

keep up the nice work fellows.

Actually when someone doesn’t understand then its up to other people that they will assist, so here it happens.

Por que contratar várias empresas para os serviços de sua casa ou empresa?

Shopping de Serviços oferece tudo o que você precisa em um só lugar.

Não perca tempo e dinheiro em vários contatos, você encontra tudo o que precisa para manter seu lar

ou negócio em ordem. Encanador, eletricista, telhadista, marido de aluguel, desentupidora, dedetizadora, laudo ART, conserto de bombas

e aquecedores. Oferecemos serviços de qualidade com os melhores

preços do mercado. Venha para Shopping de Serviços e aproveite tudo o que temos a oferecer para que você tenha segurança e conforto para sua casa ou negócio!”

I am not sure where you are getting your info, but good topic.

I needs to spend some time learning much more or understanding

more. Thanks for wonderful info I was looking for this information for my mission.

It’s very simple to find out any matter on web as compared to

textbooks, as I found this article at this web site.

Thanks for finally writing about > Пиастры – Составление семантического ядра | < Liked it!

Woah! I’m really digging the template/theme of this site.

It’s simple, yet effective. A lot of times it’s difficult to get that “perfect balance” between superb usability and visual appearance.

I must say you’ve done a very good job with this. Also, the blog loads extremely fast for me on Safari.

Excellent Blog!

Nice respond in return of this matter with genuine arguments

and telling the whole thing concerning that.

Thank you for sharing your info. I really appreciate your efforts and I

will be waiting for your further post thank you once again.

What’s Happening i am new to this, I stumbled upon this I’ve discovered It positively helpful and it has aided me out loads.

I hope to contribute & help different customers like its aided me.

Great job.

Excellent post. I was checking continuously this I care for such information a lot.

I care for such information a lot.

weblog and I am impressed! Very useful info specifically the

ultimate phase

I used to be seeking this particular information for a long time.

Thanks and good luck.

Can you tell us more about this? I’d love to find out some additional information.

I love your blog.. very nice colors & theme. Did you make this website yourself or did you hire

someone to do it for you? Plz reply as I’m looking to create my own blog and

would like to find out where u got this from. appreciate it

These are in fact wonderful ideas in on the topic of blogging.

You have touched some fastidious factors here. Any way keep up wrinting.

A Laudo ART oferece serviços de qualidade e profissionais únicos para

todas as suas necessidades em obras e reformas.

Nós realizamos laudos ART, emissão de ART, CLCB, laudos de estanqueidade,

laudos técnicos para reforma, além de

serviços de subistituição de piso e azulejo. Seja para uma pequena reforma ou para uma grande obra,

a Laudo ART tem o profissional qualificado e o serviço certo para você.

Venha conhecer todos os nossos serviços e descubra por que somos líderes em laudos ART e emissão de ART.

I’m amazed, I have to admit. Seldom do I encounter a blog that’s equally

educative and amusing, and without a doubt, you have hit the nail on the head.

The problem is an issue that not enough people are speaking intelligently about.

I’m very happy I came across this during my hunt for something

regarding this.

We are a group of volunteers and starting a new scheme in our community.

Your web site offered us with useful information to work

on. You’ve done an impressive job and our whole community shall be

grateful to you.

Today, I went to the beach with my kids. I found a sea shell and gave it to

my 4 year old daughter and said “You can hear the ocean if you put this to your ear.” She placed

the shell to her ear and screamed. There was a hermit

crab inside and it pinched her ear. She never wants to go back!

LoL I know this is entirely off topic but I had to tell someone!

Greetings! Quick question that’s entirely off topic. Do you know how to make your site mobile friendly?

My weblog looks weird when viewing from my apple iphone.

I’m trying to find a template or plugin that might be able to resolve

this issue. If you have any recommendations, please

share. Many thanks!

Very descriptive post, I liked that a lot. Will there

be a part 2?

Its like you read my mind! You appear to know a lot

about this, like you wrote the book in it or something.

I think that you could do with a few pics to drive the message home a little bit, but other

than that, this is magnificent blog. A great read. I’ll certainly be back.

This is the perfect website for anybody who wishes to

understand this topic. You understand so much its almost hard to argue with you (not that I actually will need to…HaHa).

You definitely put a fresh spin on a topic which has been discussed

for years. Excellent stuff, just wonderful!

If you are going for best contents like me, simply pay a

quick visit this web page all the time as it provides feature contents, thanks

Attractive section of content. I just stumbled upon your weblog and

in accession capital to assert that I get in fact enjoyed

account your blog posts. Any way I’ll be subscribing to your feeds and even I achievement you access

consistently quickly.

Visit the new siem reap aquarium in Cambodia

artistecard.com

Greetings! I’ve been following your site for a while now and finally got the

bravery to go ahead and give you a shout out from

Porter Texas! Just wanted to tell you keep up the good work!

Hello There. I found your blog the usage of msn. That is an extremely well written article.

I will make sure to bookmark it and come back to read

extra of your useful info. Thanks for the post. I’ll definitely return.

Aw, this was a really good post. Taking a few minutes and actual effort to produce a really good article…

but what can I say… I procrastinate a lot and don’t manage to get anything done.

When some one searches for his required thing, so he/she wants to be available that

in detail, therefore that thing is maintained over here.

I always used to study paragraph in news papers but now as I am a user

of web therefore from now I am using net for posts,

thanks to web.

Good day very cool web site!! Man .. Excellent ..

Superb .. I’ll bookmark your web site and take the feeds also?

I’m happy to seek out a lot of helpful information here within the submit, we’d like develop extra techniques in this regard,

thanks for sharing. . . . . .

I couldn’t resist commenting. Exceptionally well written!

Hi there everyone, it’s my first visit at

this website, and piece of writing is in fact fruitful

in support of me, keep up posting these articles or reviews.

OMG! This is amazing. Ireally appreciate it~ May I show back my

secrets on a secret only I KNOW and if you

want to have a checkout You really have to believe mme

and have faith and I will show how to learn SNS marketing Once again I want to show my appreciation and may

all the blessing goes to you now!.

Very good post. I will be experiencing some of these

issues as well..

Hmm is anyone else experiencing problems with

the pictures on this blog loading? I’m trying to find

out if its a problem on my end or if it’s the blog. Any suggestions would be greatly appreciated.

Thank you for the auspicious writeup. It in fact was a

amusement account it. Look advanced to more added agreeable from you!

By the way, how can we communicate?

I am truly pleased to read this blog posts which contains plenty of valuable data, thanks for providing

these kinds of data.

This post offers clear idea for the new visitors of blogging, that in fact how

to do blogging.

Very good information. Lucky me I came across your website

by chance (stumbleupon). I’ve book-marked it for later!

It’s nearly impossible to find well-informed people for this topic, but you seem like you know what you’re talking about!

Thanks

Excellent post! We are linking to this great post

on our site. Keep up the great writing.

Nice response in return of this difficulty with real arguments and

telling everything concerning that.

Hi there to all, it’s in fact a pleasant for me to pay a visit this website, it includes

priceless Information.

A empresa Encanador é a sua melhor escolha para serviços de encanamento.

Oferecemos serviços de encanador cobre, encanador 24h,

caça vazamento, laudo hidráulico, encanador PPR, encanador pex e muito mais.

Nossos profissionais são qualificados e possuem anos de experiência.

Garantimos serviços de qualidade e preços acessíveis.

Confie na Encanador e fique tranquilo com seu

encanamento.

Keep this going please, great job!

Excellent post. I was checking continuously this blog and I am impressed! I care for such info much.

I care for such info much.

Very helpful info particularly the last part

I was seeking this certain info for a very long time.

Thank you and best of luck.

I enjoy looking through a post that will make people think.

Also, thanks for allowing me to comment!

I am in fact grateful to the owner of this site who has shared

this wonderful post at here.

This site certainly has all the info I needed concerning this subject

and didn’t know who to ask.

Hi! I know this is kind of off topic but I was wondering which blog platform are you using for this website?

I’m getting fed up of WordPress because I’ve had

issues with hackers and I’m looking at options for another platform.

I would be great if you could point me in the direction of a good platform.

magnificent issues altogether, you simply received a emblem new reader.

What may you recommend in regards to your publish that you made some days in the

past? Any sure?

I was wondering if you ever thought of changing the layout of your website?

Its very well written; I love what youve got to say.

But maybe you could a little more in the way of content so people could connect with it better.

Youve got an awful lot of text for only having 1 or two images.

Maybe you could space it out better?

Its like you read my mind! You seem to know a lot about this, like you

wrote the book in it or something. I think that you could do with

a few pics to drive the message home a bit, but

instead of that, this is fantastic blog. A great read.

I’ll certainly be back.

Hello, I lօg on to your new stuff like every week.

Your writing ѕtyle is witty, keep it up!

Visit my blog post – Joker88

Hello to every body, it’s my first visit of this blog; this blog consists of remarkable and actually excellent stuff in favor of

visitors.

I read this piece of writing completely on the topic of the difference of most up-to-date and previous technologies,

it’s amazing article.

I think that is one of the such a lot vital info for me. And i’m satisfied reading your article.

But wanna statement on some basic issues, The site style is perfect,

the articles is truly great : D. Excellent task, cheers

This piece of writing is really a fastidious one it assists new web

users, who are wishing in favor of blogging.

bookmarked!!, I love your site!

I’ve been surfing on-line more than 3 hours as of late, but I never

discovered any attention-grabbing article like yours.

It’s lovely value sufficient for me. Personally, if all webmasters and bloggers made just right content material as you probably did, the web shall be a

lot more useful than ever before.

I’ve been exploring for a little bit for any high-quality articles or weblog

posts on this kind of space . Exploring in Yahoo

I at last stumbled upon this website. Reading

this info So i’m satisfied to convey that I have an incredibly excellent uncanny feeling I came upon just

what I needed. I such a lot without a doubt will make certain to do not omit this website and provides it a

glance regularly.

Hey there are using WordPress for your blog platform?

I’m new to the blog world but I’m trying to get started and create my own. Do

you need any coding expertise to make your own blog?

Any help would be greatly appreciated!

It’s wonderful that you are getting ideas from this paragraph as well as from our

argument made at this time.

I’m not sure where you are getting your info, but great topic.

I needs to spend some time learning much more or understanding more.

Thanks for great information I was looking for this information for my mission.

Hi, just wanted to tell you, I enjoyed this post.

It was inspiring. Keep on posting!

Greate post. Keep posting such kind of information on your page.

Im really impressed by your blog.

Hey there, You have done an incredible job.

I will certainly digg it and in my opinion suggest to my

friends. I’m sure they’ll be benefited from this web site.

I’m amazed, I have to admit. Seldom do I encounter a blog

that’s equally educative and amusing, and let me tell you, you’ve hit

the nail on the head. The problem is an issue that too few folks

are speaking intelligently about. I am very happy I

came across this during my search for something regarding this.

Hey would you mind letting me know which webhost you’re using?

I’ve loaded your blog in 3 different internet browsers and I must

say this blog loads a lot quicker then most. Can you recommend a

good hosting provider at a fair price? Cheers, I appreciate it!

Great article! We will be linking to this great post on our website.

Keep up the good writing.

I am genuinely thankful to the holder of this website who has shared this wonderful post at

at this time.

hello!,I really like your writing very much!

proportion we keep up a correspondence more about your article on AOL?

I require a specialist in this house to resolve my problem.

Maybe that’s you! Taking a look ahead to peer you.

I got this web page from my buddy who shared with me regarding

this web page and now this time I am browsing this web page and reading

very informative posts at this place.

I’ve been surfing online more than 3 hours lately,

but I by no means discovered any interesting article like yours.

It is pretty value sufficient for me. In my view, if all site

owners and bloggers made excellent content as you did,

the web shall be much more useful than ever before.

What’s up, this weekend is nice designed for me, since this

point in time i am reading this enormous informative post here at my home.

Fantastic goods from you, man. I’ve bear in mind your stuff prior to and you are just too magnificent.

I really like what you have received here, really like what you are saying and the best way in which you assert it.

You make it entertaining and you still take care of to

stay it smart. I can’t wait to read far more from

you. That is really a wonderful website.

I do not even know how I ended up here, but I thought this post

was good. I do not know who you are but certainly you’re going to a

famous blogger if you are not already 😉 Cheers!

Hurrah, that’s what I was searching for, what a material!

present here at this weblog, thanks admin of this web page.

Genuinely when someone doesn’t understand then its up

to other people that they will assist, so here it takes

place.

Hey There. I found your blog using msn. This is a very

well written article. I’ll be sure to bookmark

it and come back to read more of your useful info.

Thanks for the post. I’ll certainly comeback.

When someone writes an piece of writing he/she keeps the image of

a user in his/her brain that how a user can know it.

Thus that’s why this post is outstdanding. Thanks!

We are a group of volunteers and starting a new scheme in our

community. Your web site offered us with valuable information to work on. You have done a formidable job and our whole

community will be grateful to you.

Hello! I understand this is kind of off-topic however I needed

to ask. Does building a well-established blog like yours take

a lot of work? I’m completely new to operating a blog however I do write in my diary daily.

I’d like to start a blog so I can share my personal experience and feelings online.

Please let me know if you have any kind of suggestions or

tips for new aspiring bloggers. Thankyou!

I was curious if you ever thought of changing the structure of your blog?

Its very well written; I love what youve got to say. But

maybe you could a little more in the way of content so people

could connect with it better. Youve got an awful lot of text for only having 1 or 2 images.

Maybe you could space it out better?

Howdy very nice blog!! Man .. Excellent ..

Superb .. I will bookmark your blog and take the feeds additionally?

I am glad to find numerous helpful information here within the

post, we’d like develop more techniques in this regard, thank

you for sharing. . . . . .

I am not sure where you’re getting your info, but great topic.

I needs to spend some time learning much more or understanding

more. Thanks for excellent information I was looking for this info for my mission.

Hello There. I found your weblog the use of msn. This is an extremely

smartly written article. I will be sure to bookmark

it and return to learn extra of your helpful information. Thank you for the post.

I will certainly comeback.

I do not even know the way I stopped up right

here, but I assumed this post used to be good.

I don’t recognize who you’re however definitely you are

going to a famous blogger in the event you aren’t already.

Cheers!

Wonderful article! We are linking to this great content on our website.

Keep up the good writing.

Thanks for the good writeup. It if truth be told used to be a entertainment account

it. Glance advanced to more brought agreeable from you!

However, how could we keep in touch?

Pretty! This was a really wonderful post. Many thanks for providing this information.

Fucked his slutty niece who loves it when her uncle fucks her in the

ass https://cutt.ly/u87gtp5

If some one wishes expert view regarding running a blog afterward

i recommend him/her to pay a visit this weblog, Keep up the nice work.

Oh my goodness! Awesome article dude! Thank you, However I am going through difficulties with your RSS.

I don’t know why I am unable to subscribe to it.

Is there anybody getting similar RSS issues? Anyone that knows the answer will you kindly

respond? Thanks!!

I’m not sure exactly why but this site is loading very slow for me.

Is anyone else having this problem or is

it a issue on my end? I’ll check back later and see if the

problem still exists.

Hello, this weekend is fastidious for me, because this occasion i am reading this fantastic

informative paragraph here at my house.

Hey! Quick question that’s totally off topic. Do you know how to make your site mobile

friendly? My web site looks weird when browsing from my iphone.

I’m trying to find a theme or plugin that might be able to

resolve this problem. If you have any suggestions, please

share. With thanks!

Hi there i am kavin, its my first occasion to commenting anywhere, when i read this post i thought

i could also create comment due to this good post.

The policyholder can avail the benefits of

time period insurance in change of the coverage premium.

I think everything published was actually very reasonable.

However, think about this, what if you added a little

information? I mean, I don’t want to tell you how

to run your blog, but suppose you added something to possibly

grab a person’s attention? I mean Пиастры – Составление семантического ядра |

is kinda vanilla. You might peek at Yahoo’s home page and see how they

create news titles to get viewers to open the links.

You might add a related video or a picture or two to get readers excited about what you’ve written. Just my opinion,

it would make your blog a little livelier.

Very great post. I simply stumbled upon your weblog and wanted to mention that

I’ve really enjoyed surfing around your weblog posts.

After all I will be subscribing on your rss feed and I hope you write

once more very soon!

It’s a pity you don’t have a donate button! I’d definitely donate to

this outstanding blog! I suppose for now i’ll settle for

book-marking and adding your RSS feed to my

Google account. I look forward to fresh updates

and will share this site with my Facebook group. Talk soon!

I am not sure where you’re getting your info, but good topic.

I needs to spend some time learning more or understanding more.

Thanks for excellent information I was looking for this information for my mission.

I am actually happy to read this website posts which consists

of plenty of valuable information, thanks for providing these

statistics.

Thanks for sharing such a nice idea, post is good, thats why i have read it completely

Thanks for another informative site. The place else may just

I am getting that type of info written in such a perfect way?

I have a challenge that I’m simply now operating on, and

I’ve been at the glance out for such information.

Right now it seems like Drupal is the top blogging

platform available right now. (from what I’ve read) Is that what you’re using on your

blog?

That is very interesting, You’re an excessively skilled blogger.

I have joined your rss feed and look ahead to in quest of more of your fantastic

post. Also, I’ve shared your site in my social networks

It is the best time to make some plans for the future and it is time to be happy.

I’ve read this post and if I could I wish to suggest you some interesting things or tips.

Maybe you can write next articles referring to this article.

I desire to read more things about it!

It is perfect time to make some plans for the future and it’s time to be

happy. I’ve read this post and if I could

I want to suggest you some interesting things or tips.

Perhaps you can write next articles referring to this article.

I wish to read more things about it!

Heya are using WordPress for your blog platform? I’m new to the blog world but I’m trying to get started and create my own. Do you need any coding knowledge

to make your own blog? Any help would be greatly appreciated!

Wow, amazing blog layout! How lengthy have you been running a blog for?

you make blogging look easy. The entire look of your site is magnificent, as smartly as the

content!

whoah this weblog is fantastic i love reading your posts.

Keep up the good work! You already know, many people are hunting round for this info, you can help them greatly.

I like what you guys tend to be up too. This

type of clever work and coverage! Keep up the very good works guys I’ve added you guys

to our blogroll.

I do believe all of the concepts you have offered

for your post. They’re really convincing and can definitely work.

Still, the posts are very brief for beginners. Could you please lengthen them a little from next time?

Thank you for the post.

I’m gone to tell my little brother, that he should also visit this web site on regular basis to take updated from most recent reports.

My partner and I stumbled over here from a different website

and thought I may as well check things out. I like what I see so now i’m following you.

Look forward to checking out your web page yet again.

I loved as much as you’ll receive carried out right here.

The sketch is tasteful, your authored subject matter stylish.

nonetheless, you command get bought an shakiness over that you wish be delivering the following.

unwell unquestionably come more formerly again as exactly the same nearly

a lot often inside case you shield this hike.

If you would like to improve your knowledge just keep visiting this web site and be updated with

the newest news posted here.

I really love your blog.. Very nice colors & theme. Did

you build this amazing site yourself? Please reply

back as I’m trying to create my own personal website and would love to

learn where you got this from or what the theme is named.

Many thanks!

At this time I am going to do my breakfast, later than having my breakfast coming yet again to read additional news.

I have read so many articles or reviews on the topic of the blogger

lovers but this post is truly a fastidious post,

keep it up.

I every time emailed this blog post page to all my associates, for the

reason that if like to read it after that my contacts will too.

Can I simply say what a relief to uncover someone that truly understands what they’re discussing

on the internet. You certainly know how to bring a problem to light and make

it important. More people must check this out and understand this side of your story.

I can’t believe you aren’t more popular since you certainly possess the gift.

Hello, yes this piece of writing is in fact good and I have learned

lot of things from it about blogging. thanks.

Hi, i think that i saw you visited my site so i came to “return the favor”.I’m attempting to find things to enhance my web site!I suppose

its ok to use a few of your ideas!!

I do not even know how I ended up here, but I thought this post

was good. I do not know who you are but definitely

you are going to a famous blogger if you are not already 😉 Cheers!

Really no matter if someone doesn’t be aware of afterward its

up to other visitors that they will help, so here it takes place.

Simply want to say your article is as astonishing.

The clearness in your post is simply nice and

i can assume you are an expert on this subject. Well with your permission let me to grab your RSS feed to keep updated with forthcoming post.

Thanks a million and please continue the gratifying work.

Awesome blog! Is your theme custom made or did you download it

from somewhere? A theme like yours with a few simple

adjustements would really make my blog stand out.

Please let me know where you got your design. Many thanks

What i don’t understood is actually how you’re now not

actually a lot more neatly-preferred than you may be now.

You’re very intelligent. You already know therefore considerably on the subject of this subject, produced me in my opinion consider it from a lot of

various angles. Its like men and women don’t seem to be involved except it is something to accomplish with Woman gaga!

Your own stuffs outstanding. Always take care of it up!

Thanks for one’s marvelous posting! I definitely enjoyed reading it, you’re a great author.

I will always bookmark your blog and may come back

in the future. I want to encourage yourself to continue your great writing, have

a nice evening!

I would like to thank you for the efforts you have put in penning this website.

I really hope to view the same high-grade content by you later on as well.

In truth, your creative writing abilities has encouraged me to get my very own blog now 😉

hi!,I really like your writing very so much! share we communicate more

approximately your post on AOL? I require an expert in this area to unravel my problem.

Maybe that is you! Looking ahead to see you.

Hello, I think your site might be having browser

compatibility issues. When I look at your blog in Firefox,

it looks fine but when opening in Internet Explorer, it has some

overlapping. I just wanted to give you a quick heads up!

Other then that, fantastic blog!

Good info. Lucky me I ran across your site by accident (stumbleupon).

I have bookmarked it for later!

wonderful post, very informative. I ponder why the opposite experts of

this sector don’t notice this. You should continue

your writing. I am sure, you’ve a great readers’ base already!

Heya! I understand this is sort of off-topic however I had

to ask. Does operating a well-established website like

yours require a lot of work? I’m brand new to operating a blog but I do write in my journal daily.

I’d like to start a blog so I can easily share my personal

experience and thoughts online. Please let me know if you have any kind of recommendations or tips for brand new aspiring blog owners.

Appreciate it!

Genuinely no matter if someone doesn’t know then its up to other people that they will

help, so here it happens.リアルドール

Hey great website! Does running a blog such as this require a massive amount work?

I have very little knowledge of computer programming but I

was hoping to start my own blog soon. Anyways, if you have any

recommendations or techniques for new blog owners please share.

I understand this is off subject but I simply had to ask.

Many thanks!

I believe people who wrote this needs true loving because it’s a blessing.

So let me give back and finally give back change your life and if you want

to seriously get to hear I will share info about how to become a millionaire Don’t forget..

I am always here for yall. Bless yall!

If some one desires expert view about blogging

and site-building after that i advise him/her to pay a quick visit this website,

Keep up the pleasant job.

Wow, marvelous weblog structure! How lengthy have you ever been blogging for?

you make running a blog glance easy. The overall glance of your site is fantastic, let alone the content material!

Thanks a lot for sharing this with all folks you

actually understand what you are talking about! Bookmarked.

Kindly also talk over with my web site =). We may have a hyperlink alternate arrangement

among us

I feel this is among the such a lot vital information for me.

And i’m happy studying your article. But want to statement on some basic things, The website style is ideal, the articles is really great :

D. Excellent activity, cheers

You are so cool! I do not think I have read through

anything like that before. So great to find someone with original thoughts on this subject.

Seriously.. thanks for starting this up. This website is one thing that is needed on the web, someone with a bit of originality!

I am really impressed with your writing skills and also with

the layout on your weblog. Is this a paid theme or did you customize it yourself?

Either way keep up the excellent quality writing, it’s rare to see a nice blog like this

one nowadays.

Spot on with this write-up, I really believe that this

website needs a great deal more attention. I’ll probably be returning to see more, thanks

for the info!

I know this if off topic but I’m looking into starting my own blog and was curious what all is needed to get setup?

I’m assuming having a blog like yours would cost a

pretty penny? I’m not very internet savvy so I’m

not 100% sure. Any recommendations or advice would be greatly appreciated.

Appreciate it

I truly love your blog.. Excellent colors & theme. Did you make this amazing site yourself?

Please reply back as I’m planning to create my own website and

want to learn where you got this from or exactly what the theme is called.

Kudos!

Please let me know if you’re looking for a article writer for your site.

You have some really great posts and I believe I would be a

good asset. If you ever want to take some of the load off, I’d really like to write some content for your blog in exchange

for a link back to mine. Please shoot me an email if interested.

Kudos!

I could not refrain from commenting. Very well written!

Hiya! Quick question that’s completely off topic.

Do you know how to make your site mobile friendly? My site looks

weird when viewing from my apple iphone. I’m trying

to find a theme or plugin that might be able to correct this issue.

If you have any recommendations, please share. Many

thanks!

Normally I do not read post on blogs, however I wish to say that this write-up very compelled me

to take a look at and do so! Your writing taste has been amazed me.

Thanks, quite nice article.

Feel free to surf to my page … Honeybee Pharmacy

Incredible points. Great arguments. Keep up the good spirit.

I blog quite often and I really appreciate your content.

This great article has really peaked my interest.

I am going to take a note of your website and keep checking for

new information about once a week. I opted in for your RSS feed as well.

Excellent blog here! Also your web site loads up fast!

What host are you using? Can I get your affiliate link

to your host? I wish my site loaded up as fast

as yours lol

Hi there! Someone in my Facebook group shared this

site with us so I came to take a look. I’m definitely

enjoying the information. I’m bookmarking and will be tweeting this to my followers!

Superb blog and amazing design and style.

Fine way of explaining, and good article to take data concerning my presentation subject matter,

which i am going to convey in college.

Howdy would you mind letting me know which hosting company you’re using?

I’ve loaded your blog in 3 different browsers and I must say this blog loads a lot quicker then most.

Can you suggest a good web hosting provider at a reasonable price?

Thank you, I appreciate it!

Thanks for every other informative web site. Where else may just I am getting that kind of information written in such an ideal method?

I have a challenge that I’m just now running

on, and I have been at the glance out for such information.

Hi to all, the contents present at this website are truly amazing

for people knowledge, well, keep up the nice work fellows.

I am not sure the place you are getting your info,

but good topic. I needs to spend some time studying much

more or understanding more. Thank you for magnificent information I used to be looking for this info for my mission.

Hey there! This is my first visit to your blog! We are a collection of

volunteers and starting a new initiative in a community in the same niche.

Your blog provided us useful information to work on. You have

done a marvellous job!

At this time I am going to do my breakfast, after having my breakfast coming yet again to read more

news.